1. 서론: Meta LLaMA 2란?

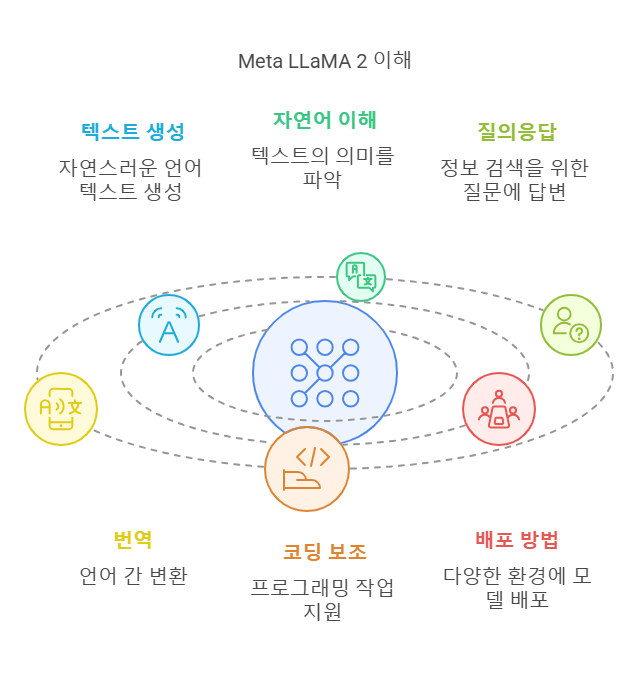

**Meta LLaMA 2 (Large Language Model Meta AI)**는 Meta AI에서 개발한 **오픈 소스 대규모 언어 모델(SLLM)**로, 텍스트 생성, 자연어 이해, 질의응답, 번역, 코딩 보조 등 다양한 자연어 처리(NLP) 작업에 강력한 성능을 제공합니다.

LLaMA 2는 상용 사용이 허용된 무료 오픈 소스 모델로, 개발자와 기업 모두 사용할 수 있습니다. 이 가이드는 Meta LLaMA 2 구축 방법을 클라우드, 로컬, 컨테이너 환경(Docker) 기준으로 상세히 설명합니다.

목차

- Meta LLaMA 2 개요 및 요구 사항

- LLaMA 2 모델 설치 준비

- LLaMA 2 모델 설치 (로컬 환경)

- LLaMA 2 모델 Docker 환경 설치

- LLaMA 2 클라우드 배포 (AWS/GCP/Azure)

- Hugging Face 모델 사용 및 API 설정

- LLaMA 2 실행 및 테스트

- LLaMA 2 활용 사례 및 추천 설정

- 문제 해결 및 권장 사항

- 결론 및 추가 리소스

1. Meta LLaMA 2 개요 및 요구 사항

1.1 Meta LLaMA 2 특징

- 개발사: Meta AI

- 출시일: 2023년 7월

- 모델 크기: LLaMA 2-7B, LLaMA 2-13B, LLaMA 2-70B (파라미터 수 기준)

- 사용 사례: 텍스트 생성, 질문 응답, 번역, 코드 생성, 챗봇 구축 등

- 오픈 소스 라이선스: 상용 및 개인 사용 가능 (상업적 프로젝트 허용)

1.2 시스템 요구 사항 (기본)

| 구성 요소 | 권장 요구 사항 |

|---|---|

| OS | Linux (Ubuntu 20.04+), Windows, macOS |

| Python 버전 | Python 3.9 이상 |

| GPU (필수 아님) | NVIDIA GPU (CUDA 지원) |

| RAM | 최소 16GB (70B 모델은 48GB 이상 권장) |

| 디스크 공간 | 최소 20GB (모델 파일 저장용) |

2. LLaMA 2 모델 설치 준비

2.1 GPU 및 CUDA 드라이버 설치 (옵션)

LLaMA 2는 GPU 지원이 권장되며, NVIDIA CUDA 드라이버가 필요합니다.

GPU 드라이버 설치:

<bash>

# NVIDIA 드라이버 설치

sudo apt update

sudo apt install nvidia-driver-525

CUDA 설치 확인:

<bash>

nvidia-smi

2.2 파이썬 환경 설정

<bash>

# Python 3.9 이상 설치 확인

python3 --version

가상환경 생성 (권장)

<bash>

# 가상환경 생성 및 활성화

python3 -m venv llama2-env

source llama2-env/bin/activate

필수 라이브러리 설치

<bash>

# pip 최신화

pip install --upgrade pip

# 필수 라이브러리 설치

pip install torch transformers accelerate

3. LLaMA 2 모델 설치 (로컬 환경)

3.1 Hugging Face 모델 다운로드 및 설치

- Hugging Face 모델 다운로드:

<bash>

pip install huggingface_hub2. Hugging Face CLI 로그인:

<bash>

huggingface-cli login

3.2 LLaMA 2 모델 다운로드

<bash>

# Transformers 라이브러리 설치 (최신 버전)

pip install transformers

# LLaMA 2-7B 모델 다운로드

from transformers import AutoTokenizer, AutoModelForCausalLM

# 모델 로드

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-hf")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-hf", device_map="auto")

3.3 모델 실행 및 테스트 코드

<python>

# 텍스트 생성 테스트

from transformers import pipeline

# 텍스트 생성 파이프라인

generator = pipeline("text-generation", model=model, tokenizer=tokenizer)

# 텍스트 생성 결과 출력

response = generator("LLaMA 2란 무엇인가요?", max_length=100)

print(response)

4. LLaMA 2 모델 Docker 환경 설치

4.1 Docker 설치

<bash>

# Docker 설치 (Ubuntu)

sudo apt update

sudo apt install docker.io

4.2 Docker 컨테이너 실행

<bash>

# Hugging Face 모델 다운로드 Docker 이미지 사용

docker run -it --gpus all --rm huggingface/transformers-pytorch-gpu:latest

4.3 Docker 내부에서 모델 실행

<python>

from transformers import AutoTokenizer, AutoModelForCausalLM

# LLaMA 2 모델 다운로드 및 실행

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-2-7b-hf")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-2-7b-hf", device_map="auto")

5. LLaMA 2 클라우드 배포 (AWS/GCP/Azure)

LLaMA 2 모델은 AWS EC2, Google Cloud, Azure VM 등 클라우드 플랫폼에서도 배포할 수 있습니다.

5.1 AWS 배포 (예시)

- AWS EC2 인스턴스 생성 (GPU 지원).

- SSH 접속 후 환경 설정.

- LLaMA 2 설치 및 실행.

6. Hugging Face 모델 사용 및 API 설정

6.1 Hugging Face Space API 배포

- Hugging Face Spaces에 로그인 후 새로운 앱 생성

- LLaMA 2 모델 배포 시 자동 API 생성

7. LLaMA 2 실행 및 테스트

<python>

# 텍스트 생성 예제

from transformers import pipeline

# 텍스트 생성기 로드

generator = pipeline("text-generation", model=model, tokenizer=tokenizer)

# 텍스트 생성

response = generator("Meta LLaMA 2의 주요 기능은?", max_length=200)

print(response)

8. LLaMA 2 활용 사례 및 추천 설정

- 챗봇 개발: 고객 서비스, 지원 봇.

- 텍스트 생성: 콘텐츠 생성, 문서 작성.

- 언어 번역: 실시간 번역 서비스.

- 코딩 지원: 코드 생성 및 디버깅.

9. 문제 해결 및 권장 사항

- CUDA 오류 발생 시: NVIDIA 드라이버 재설치.

- Hugging Face 로그인 문제: API 토큰 생성 후

huggingface-cli login실행. - 메모리 부족 문제: GPU 메모리 업그레이드 또는 CPU 실행 전환.

10. 결론 및 추가 리소스

이 가이드를 통해 Meta LLaMA 2 모델 설치, 실행 및 배포 절차를 로컬, Docker, 클라우드 환경 기준으로 자세히 설명했습니다. 오픈 소스 라이선스를 통해 상업적 프로젝트 개발에도 사용할 수 있으며, 다양한 NLP 작업에서 강력한 성능을 발휘할 수 있습니다.

추가 리소스:

🚀 성공적인 LLaMA 2 AI 모델 개발을 기원합니다! 🚀

2930 Blog에서 더 알아보기

구독을 신청하면 최신 게시물을 이메일로 받아볼 수 있습니다.